近日,我院机器智能团队在“无源领域自适应问题”(Source-Free Domain Adaptation)上取得系列研究成果,发表在人工智能、计算机视觉领域顶级期刊International Journal of Computer Vision (IJCV) 和多媒体领域顶级期刊IEEE Transactions on Multimedia(TMM)。两篇文章第一作者均为唐宋副教授,合作者包括Universität Hamburg Prof. Dr. Jianwei Zhang、电子科技大学叶茂教授、University of Surry Prof. Xiatian Zhu,以及清华大学张长水教授。

IJCV(影响因子19.6)与IEEE TPAMI、JMLR、AI是中国计算机学会(CCF)推荐的人工智能领域的4个A类期刊,其中IJCV在四个期刊里发文量相对较低,年发文量仅约130篇。据Web of Science网站显示,此篇论文是我校首篇IJCV论文。TMM(影响因子7.2)是CCF推荐的B类期刊,清华大学计算机学科群推荐A类期刊,中科院一区、TOP期刊。

背景:“领域自适应”是迁移学习的基础问题。当前,数据被作为企业核心资产,以及国家竞争的战略资源,受到严格保护,源数据获取变得异常困难,信息安全成为越来越多AI应用的刚性需求。2021年以来,无源领域自适应逐渐成为领域自适应研究的前沿热点之一。

IJCV论文:Source-Free Domain Adaptation via Target Prediction Distribution Searching

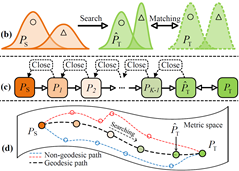

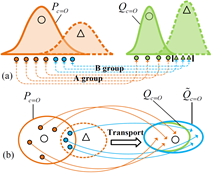

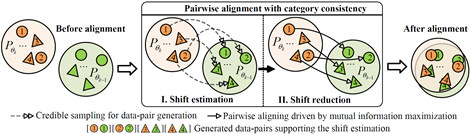

无源领域自适应的主要难点是:在欠信息条件下,减小跨域的概率分布差异。现有方法挖掘辅助信息来缓解信息不足,再进行特征分布对齐。这种方案具有一个基础性局限:在无监督约束下挖掘的辅助信息通常含有大量的噪声,同时又缺乏有效的误差消减机制。为了克服该局限,我们提出了目标预测分布搜索(TPDS)的新范式。理论上,我们证明在当分布偏移足够小的情况下,域转移误差是有界的。为了满足这个条件,我们引入代理分布流,来刻画源域与目标域之间的分布差异,从而实现沿着测地线的概率分布搜索,在此过程中,相邻分布被加以最小分布差异约束,使得总体误差最小。考虑到代理分布之间的顺序相关性,我们提出一种新的基于Wasserstein数据对的松弛类别一致算法,来控制迁移路径上相邻概率分布之间分布差异。具体地,我们首先基于数据流形假设,设计跨分布搜索方法构建支持 Wasserstein距离计算的数据对,实现领域差异估计;然后最大化这些数据对的互信息实现领域差异最小化。在五个挑战性数据集进行的实验表明 TPDS 取得了新的SOTA性能。

(A) 面向误差控制的概率空间中测地线搜索 (B) 基于Wasserstein距离的分布差异计算

(C) 基于互信息熵的分布差异最小化算法

图1 目标预测分布搜索新范式基本思路示意图

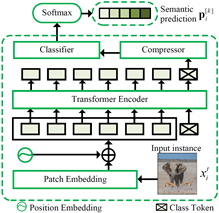

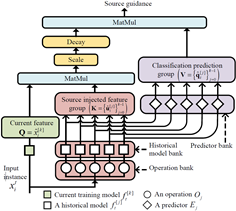

TMM论文:Progressive Source-Aware Transformer for Generalized Source-Free Domain Adaptation

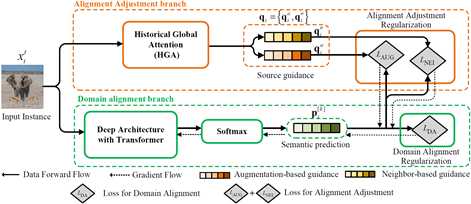

与其他机器学习方法类似,无源领域自适应亦存在灾难性遗忘挑战。最近,通用无源领域自适应方向(GSFDA)受到关注,其旨在同时提高目标域与源域性能。现有方法通过保留与源域相关的模型参数,来防止遗忘。但是,这种优先考虑减轻源域遗忘的策略,不利于提升在目标域上的跨域性能。为解决这一关键缺陷,本文提出了关注源域的渐进式Transformer方法,即PSAT-GDA,其核心思想是:通过施加源域引导,强制迁移过程记住源域,从而构建以目标领域为中心的抗遗忘新范式。具体地,我们首先利用一个 Transformer 深度网络来进行域对齐,从图像块层级,减少由领域偏移引起的图像语义噪声。同时,另一个新设计的Transformer 构造源引导监督域对齐。在该Transformer中,我们提出了一种通用的历史全局注意力机制(Historical Global Attention)。首先,通过数据增强,以及从历史模型中挖掘源信息,构建源注入特征组;然后,自注意力模块为每个目标样本选择有用的源信息。以此为基础,我们设计了基于最近邻几何结构和随机数据增强的正则化方法来构造源引导。实验表明我们的方法可以在目标领域获得明显迁移性能改进;而且,当模型向单个或多个目标域迁移后,它具有明显的抗遗忘能力。

(A) PSAT-GDA框架

(B) 去除图像语义噪声的Transformer (C) 历史全局注意力机制

图2 以目标领域为中心的防遗忘新范式

论文链接

[1] https://doi.org/10.1007/s11263-023-01892-w

[2] https://doi.org/10.1109/TMM.2023.3321421